Depuis son lancement, ChatGPT Search se présente comme une alternative innovante aux moteurs de recherche traditionnels comme Google et Bing. OpenAI met en avant des efforts pour collaborer avec les éditeurs de contenu, notamment grâce à des accords de licence et la prise en compte des préférences exprimées dans les fichiers robots.txt. Pourtant, une étude récente menée par le Tow Center de l’Université de Columbia remet en question la fiabilité des réponses générées par cet outil.

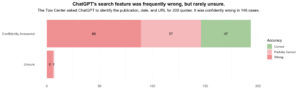

L’analyse du Tow Center, basée sur 200 citations provenant de 20 éditeurs différents, montre que ChatGPT Search peine à identifier correctement les sources. Dans 75 % des cas, les citations ont été mal attribuées ou incorrectes, parfois même liées à des contenus plagiés. Par exemple, un article original du New York Times, inaccessible à ChatGPT en raison d’un blocage, a été référencé à partir d’un site tiers non autorisé. Ces erreurs soulignent un manque de rigueur dans la manière dont l’outil traite et attribue les contenus.

Ces failles posent de réels problèmes pour les éditeurs. Lorsque les informations sont mal attribuées ou présentées de manière incohérente, cela peut nuire à leur visibilité et leur crédibilité. De plus, l’absence de transparence dans la provenance des réponses risque de brouiller la relation de confiance entre les utilisateurs et les médias. Certains éditeurs craignent également que leurs contenus soient davantage associés à des versions plagiées qu’à leurs publications originales.

OpenAI affirme vouloir améliorer son outil en respectant les éditeurs et en augmentant la précision des réponses. Toutefois, l’étude du Tow Center montre qu’il reste encore beaucoup à faire pour garantir des résultats fiables et cohérents. Si ChatGPT Search souhaite devenir une véritable alternative aux moteurs de recherche classiques, des efforts significatifs seront nécessaires pour protéger les éditeurs et restaurer la confiance des utilisateurs.